Header-Bild:ChatGPT

Website-Crawl und technische SEO-Analyse

Der Screaming Frog SEO Spider ist ein leistungsstarkes Website-Crawling-Tool, das speziell für die technische SEO-Analyse und Onpage-Optimierung entwickelt wurde. Das Tool simuliert das Verhalten von Suchmaschinen-Crawlern und analysiert Websites URL für URL, um technische Fehler, strukturelle Schwächen und Optimierungspotenziale sichtbar zu machen.

Screaming Frog eignet sich sowohl für schnelle SEO-Checks einzelner Seiten als auch für tiefgehende technische Audits ganzer Websites. Besonders geschätzt wird das Tool für seine Transparenz, Detailtiefe und die Möglichkeit, SEO-Probleme unabhängig von externen Datenquellen direkt auf URL-Ebene zu identifizieren.

Kostenlos vs. Lizenzversion

Kostenlose Version

Die kostenlose Version des Screaming Frog SEO Spider erlaubt das Crawlen von bis zu 500 URLs pro Website und eignet sich hervorragend für:

- kleinere Websites und Blogs

- erste technische SEO-Checks

- punktuelle Onpage-Analysen

- Schulungs- und Lernzwecke

Bereits in der Free-Version stehen zentrale Funktionen wie Statuscode-Analyse, Meta-Daten-Auswertung und interne Verlinkungsanalysen zur Verfügung.

Lizenzversion (kostenpflichtig)

Die kostenpflichtige Version hebt diese Einschränkungen auf und richtet sich vor allem an:

- größere Websites und Online-Shops

- Agenturen und professionelle SEOs

- regelmäßige technische Audits

Zusätzlich werden erweiterte Funktionen wie JavaScript-Crawling, API-Anbindungen, geplante Crawls und umfangreiche Exporte freigeschaltet.

Wofür eignet sich Screaming Frog besonders?

Screaming Frog ist damit ein klassisches Analyse- und Kontrolltool, das vor allem im Zusammenspiel mit der Google Search Console seine Stärken ausspielt. Es eignet sich für:

- Technische SEO-Audits

- Onpage-Analysen auf URL-Ebene

- Fehleranalyse nach Relaunches oder Migrationen

- Überprüfung von Weiterleitungen, Canonicals und Indexierungssteuerung

- Kontrolle der internen Verlinkung und Seitenstruktur

Wichtige Funktionen und Features

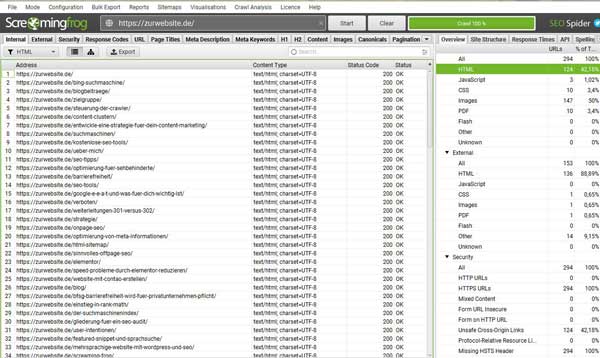

Crawling & Statuscodes

- Analyse von HTTP-Statuscodes (200, 301, 302, 404, 500 etc.)

- Erkennung von Weiterleitungsketten und Redirect-Loops

- Prüfung von HTTPS, Mixed Content und Protokollfehlern

Meta-Daten & Onpage-Elemente

- Title-Tags (fehlend, zu lang, doppelt)

- Meta-Descriptions (fehlend, doppelt)

- Überschriften-Struktur (H1–H6)

- Analyse von Canonical-Tags

- Meta-Robots (index / noindex)

Interne & externe Verlinkung

- Interne Linkstruktur

- Klicktiefe (Crawl Depth)

- Orphan Pages ( verwaiste Seiten, auf die nicht verlinkt wird)

- In- und Outlinks je URL

- Broken Links (intern & extern)

Medien & Ressourcen

- Bilder ohne Alt-Attribut

- Analyse von Dateigrößen

- Prüfung eingebundener Ressourcen (CSS, JS)

Struktur & Technik

- XML-Sitemap-Analyse

- robots.txt-Prüfung

- URL-Struktur & Parameter

- Pagination & hreflang-Checks

- Duplicate Content (Seitentitel, Descriptions, Inhalte)

Erweiterte Funktionen (nur mit Lizenz)

- JavaScript Rendering

- Custom Extraction (XPath, Regex, CSS-Selector)

- Google Analytics & Search Console API-Integration

- Geplante Crawls & automatisierte Reports

Kurzum: Für mich gehört der Crawler zu den wichtigsten Tools bei der täglichen SEO-Arbeit. Die Website zum Tool findest du hier: https://www.screamingfrog.co.uk/seo-spider/